L’AI nei luoghi di lavoro, gli obblighi per le imprese

Lavoratrici e Lavoratori Aci Informatica - Sunday, October 26, 2025(Fonte) Area Innovazione e AI – 23 ottobre 2025

L’AI ACT visto dall’impresa

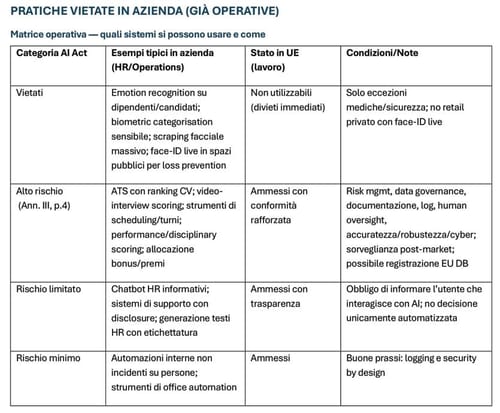

Dal 2 febbraio 2025 l’AI Act vieta: emotion recognition in luoghi di lavoro; social scoring; sfruttamento di vulnerabilità; sistemi di identificazione biometrica remota in tempo reale in spazi pubblici (salve strette eccezioni di polizia); biometric categorisation per tratti sensibili; untargeted scraping di immagini facciali per creare database.

Impatto per i datori di lavoro: nessun “sentiment scoring” su dipendenti/candidati; no face recognition in tempo reale in aree accessibili al pubblico (es. retail) per scopi di loss prevention; attenzione ai sistemi che deducono tratti sensibili. Le linee-guida della Commissione sui divieti hanno chiarito casistiche e confini applicativi (cfr. Strategia Digitale Europea).

L’AI Act qualifica come altro rischio i sistemi utilizzati nelle funzioni HR (Allegato III: reclutamento, selezione, assegnazione dei compiti, valutazione delle performance, decisioni su promozioni o cessazioni). Per questi sistemi si applicano obblighi stringenti: risk management, governance e qualità dei dati, documentazione tecnica, registrazione nel database UE, sorveglianza post-market, human oversight effettivo, requisiti di accuratezza, robustezza e cybersecurity. La piena applicazione sarà guidata dagli standard tecnici europei (CEN-CENELEC JTC 21), che fungeranno da vero e proprio manuale operativo.

Anche i deployer (le aziende che usano questi sistemi) sono soggetti a obblighi: uso conforme alle istruzioni, supervisione umana, logging delle attività, qualità dei dati e, dove previsto dagli Stati membri, valutazione d’impatto sui diritti fondamentali (FRIA). Le scadenze principali si applicano in modo progressivo tra 2026 e 2027. L’insieme di questi adempimenti comporta un impatto organizzativo significativo, richiedendo risorse, competenze e adeguamenti procedurali rilevanti.

Sanzioni e governance (AI Act + L. 132/2025)

L’AI Act prevede sanzioni molto elevate: fino a 35 milioni di euro o il 7% del fatturato globale per le pratiche vietate; 3% per altre violazioni e 1% in caso di informazioni false o fuorvianti. La governance è affidata all’AI Office UE e alle autorità nazionali di vigilanza, formalmente designate dal 10 ottobre 2025, responsabili di controllo e enforcement.

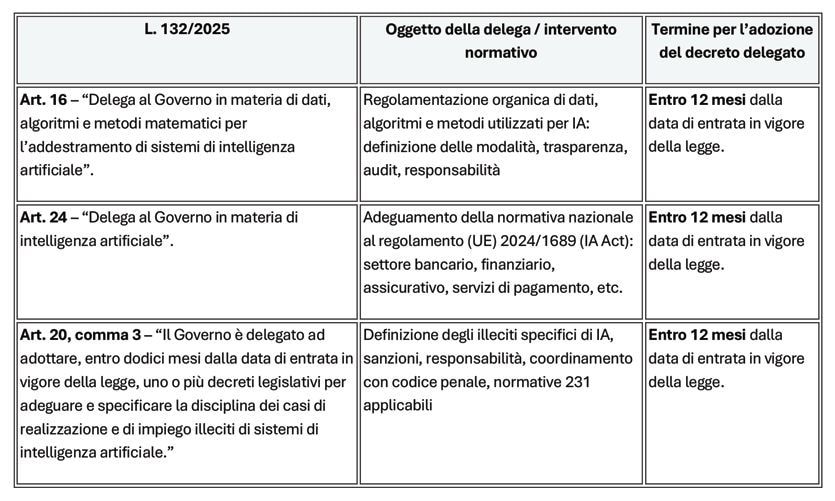

Con la L. 132/2025, l’Italia coordina l’ordinamento interno all’AI Act, introducendo principi generali, misure di promozione, prime fattispecie penali e un quadro di riferimento nazionale.

Focus lavoro

-

L’art. 11 stabilisce che l’uso dell’IA nel lavoro deve migliorare le condizioni lavorative, rispettare dignità, integrità psico-fisica, sicurezza, trasparenza e protezione dei dati, bilanciando diritti dei lavoratori e interessi d’impresa.

-

È previsto l’obbligo di informativa al lavoratore sull’uso dell’IA (richiamo al Decreto Trasparenza) e garanzie antidiscriminatorie esplicite.

-

L’art. 12 istituisce un Osservatorio nazionale presso il Ministero del Lavoro, con funzioni di monitoraggio, dialogo sociale e promozione della formazione su IA per lavoratori e datori.

Il quadro sanzionatorio e regolatorio sarà progressivo e in evoluzione, poiché molte disposizioni richiedono decreti attuativi che definiranno nel concreto obblighi, procedure e controlli.

Gli obblighi informativi (Artt. 13 e 15 GDPR)

Nel contesto lavorativo, l’uso di sistemi di IA è oggi regolato da un insieme coordinato di norme che impongono trasparenza, supervisione umana, non discriminazione e sicurezza dei dati. Il GDPR rappresenta il pilastro degli obblighi informativi: gli articoli 13, paragrafo 2, lettera f), e 15, paragrafo 1, lettera h) e il Considerando 71 del GDPR impongono al titolare del trattamento di fornire informazioni chiare sull’esistenza di processi decisionali automatizzati, sulle logiche utilizzate e sulle loro conseguenze per l’interessato. L’informativa deve spiegare anche metriche, logiche algoritmiche, meccanismi di controllo degli errori e dei bias, evitando informative generiche. Il provvedimento n. 408 del 15 dicembre 2023 del Garante per la protezione dei dati personali ha chiarito che, quando un algoritmo incide su assunzioni, premi o provvedimenti disciplinari, le informative devono includere la logica di funzionamento del modello, i parametri più rilevanti e la possibilità di intervento umano (il c.d. man in the loop).

Decisioni automatizzate e garanzie (art. 22 e considerando 71 GDPR)

L’articolo 22 del GDPR riconosce all’interessato il diritto di non essere sottoposto a decisioni fondate unicamente su trattamenti automatizzati di dati personali, comprese le attività di profilazione, qualora tali decisioni producano effetti giuridici o incidano in modo analogo sulla sua sfera personale.

Nei casi in cui il processo decisionale automatizzato venga presentato come necessario per l’esecuzione di un contratto (con una verifica della reale indispensabilità del trattamento come chiarito dalle Linee guida 2/2019 del Comitato Europeo per la Protezione dei Dati), autorizzato dal diritto dell’Unione o dello Stato membro, oppure basato sul consenso esplicito dell’interessato, il titolare deve garantire adeguate tutele, tra cui l’intervento umano, la possibilità di esprimere opinioni e di contestare la decisione (Considerando 71)

Il lavoratore deve sapere chi può modificare o annullare una decisione automatizzata e in quali tempi.

L’integrazione con l’AI Act: trasparenza e spiegabilità

L’AI Act, negli articoli 13 e 14, introduce obblighi specifici di trasparenza e fornitura di informazioni agli utenti e agli interessati. Tali obblighi si sommano, ma non si sovrappongono, a quelli del GDPR, prevedendo che:

- gli utilizzatori di sistemi di alto rischio debbano garantire che il personale umano comprenda le capacità e i limiti del sistema

- l’adozione di misure per assicurare la supervisione umana durante tutto il ciclo di vita del sistema.

A tal proposito si sollevano due aspetti fondamentali:

- laddove i prodotti utilizzati derivino da servizi digitali erogati da fornitori terzi, bisogna porre particolare attenzione a tutto il processo di fornitura per assicurare la spiegabilità dell’algoritmo, a partire dal contratto.

- il monitoraggio ed eventuali audit in tali casi debbono essere ripensati e organizzati opportunamente.

Statuto dei Lavoratori (artt. 4, 8, 15), prassi Garante e giurisprudenza 2023–2025

Nella prospettiva dell’impresa (e del datore di Lavoro in genere), lo Statuto dei Lavoratori conserva un ruolo centrale nella regolazione del rapporto tra controllo tecnologico e diritti dei lavoratori. L’introduzione di sistemi di intelligenza artificiale e di analisi automatizzata delle prestazioni richiede un accenno alla lettura sistematica degli articoli 4, 8 e 15 alla luce dell’evoluzione tecnologica e delle più recenti pronunce della giurisprudenza e del Garante per la protezione dei dati personali.

- Strumenti di controllo a distanza e AI come ‘strumento di lavoro’ (art. 4 St. Lav.): l’introduzione di sistemi di intelligenza artificiale non elimina, ma anzi amplifica il rischio di controllo indiretto (perchè occorre ricordare che quello diretto sulle modalità della prestazione era ed è vietato, divenuto principio dell’Ordinamento dopo la modifica del 2015, per giurisprudenza granitica) della persona del lavoratore.

La norma distingue tra strumenti di controllo a distanza – soggetti ad accordo sindacale o autorizzazione dell’INL – e strumenti di lavoro funzionali alla prestazione o alla sicurezza, nozione sempre interpretata in modo restrittivo da Garante e giudici.

Nel contesto dell’IA questa distinzione si fa problematica: software di pianificazione turni, analisi produttiva, gestione HR o valutazione automatizzata svolgono congiuntamente funzioni organizzative e di controllo, rientrando così nel perimetro dell’art. 4. La giurisprudenza recente ha chiarito che anche sistemi digitali apparentemente neutrali sono soggetti alle garanzie dello Statuto se producono effetti di monitoraggio diretto o indiretto sulle prestazioni. Il Garante (parere n. 477/2024 e provvedimenti 2022–2024) ha inoltre ribadito che tali strumenti richiedono DPIA, informativa specifica e valutazione congiunta con DPO e rappresentanze, poiché metriche di produttività, presenza o performance costituiscono controllo a distanza.

L’algoritmo non può sostituire la supervisione umana: il datore resta titolare e responsabile del trattamento. Ai sensi dell’art. 4, comma 2, i dati raccolti attraverso strumenti di lavoro possono essere utilizzati solo nel rispetto delle garanzie procedurali previste e, quando il monitoraggio è sistematico o profilato, previo accordo sindacale.

- Divieto di indagini sulle opinioni e limiti informativi dei sistemi AI (art. 8 St. Lav.): L’articolo 8 dello Statuto dei Lavoratori vieta al datore di lavoro di raccogliere, direttamente o tramite terzi, informazioni sulle opinioni politiche, religiose o sindacali del lavoratore e, più in generale, su aspetti non rilevanti ai fini della valutazione professionale. Con l’avvento dell’IA, questo divieto si estende anche alle analisi inferenziali basate su dati comportamentali, linguistici o provenienti dal social listening: anche senza domande dirette, infatti, un algoritmo può dedurre opinioni o caratteristiche sensibili, violando lo spirito della norma.

Il Garante ha già ritenuto illecito l’uso di software di analisi del linguaggio nei colloqui di selezione, perché in grado di rivelare tratti personali non pertinenti. Analogamente, i sistemi di “well-being” o di emotion AI, spesso proposti come strumenti per misurare engagement o benessere, rischiano di sconfinare nei controlli vietati dagli artt. 4 e 8, salvo configurazioni strettamente orientate a finalità lecite e proporzionate. In questo ambito vale in forma rafforzata il principio di pertinenza e non eccedenza: l’IA può trattare solo dati realmente necessari alla funzione lavorativa.

La giurisprudenza conferma tale indirizzo: la Cassazione, con sentenza n. 25731/2021, ha giudicato illegittimo l’uso di analisi comportamentali sulle chat aziendali a fini disciplinari, ritenendo tali controlli eccedenti e vietati dall’art. 8.

- Divieto di atti discriminatori e valutazioni algoritmiche (art. 15 St. Lav.): L’articolo 15 dello Statuto dei Lavoratori sancisce la nullità degli atti discriminatori e vieta ogni trattamento differenziato basato su sesso, età, orientamento, razza o convinzioni personali. Nel contesto dell’IA ciò implica l’obbligo di testare i sistemi algoritmici per individuare bias e correlazioni spurie, prevenendo effetti discriminatori nelle decisioni di selezione o gestione del personale. Poiché i modelli si alimentano dei dati prodotti dai processi aziendali, la qualità e correttezza dei dati diventa essenziale: dati distorti o degradati generano modelli errati e potenzialmente discriminatori. Ne deriva per il datore di lavoro un preciso onere di verifica e controllo sulle modalità di acquisizione e trattamento dei dati.

Il datore deve inoltre documentare i test, mantenere tracciabilità delle decisioni automatizzate e dimostrare la correttezza del processo, in coerenza con il Considerando 71 GDPR, con i principi di fairness dell’AI Act e con la normativa antidiscriminatoria (D.lgs. 215/2003, 216/2003 e 198/2006). Poiché nel rito antidiscriminatorio è ammesso l’uso della prova statistica, anche i bias sistemici rientrano nel perimetro della responsabilità datoriale. L’integrazione tra Statuto, GDPR, AI Act e norme antidiscriminazione è quindi cruciale per prevenire impact discrimination in ambito HR, sebbene la complessità del quadro rischi di renderne difficile un’effettiva prevenzione ex ante da parte delle imprese.

Gestione dei dati, responsabilità organizzativa e tutela della salute e sicurezza nei luoghi di lavoro

L’evoluzione dell’intelligenza artificiale nelle imprese si intreccia con un più ampio quadro normativo che coinvolge la gestione dei dati, la responsabilità organizzativa e la tutela della salute e sicurezza nei luoghi di lavoro. Il Data Act, la Legge 132/2025, il D.Lgs. 231/2001 e il D.Lgs. 81/2008 rappresentano i pilastri di una governance integrata che deve garantire, in chiave sistematica, trasparenza, tracciabilità e sicurezza tecnologica.

Il Data Act (Reg. UE 2023/2854) stabilisce regole uniformi per l’accesso e l’utilizzo dei dati generati da prodotti e servizi connessi, inclusi quelli derivati da sistemi di IA, e completa l’AI Act garantendo accesso e portabilità dei dati anche in ambito aziendale. Ciò implica che i dati raccolti da sensori, macchinari intelligenti e software predittivi devono essere accessibili in modo equo, sicuro e interoperabile, nel rispetto del GDPR.

Per i datori di lavoro il Data Act introduce nuovi obblighi di governance dei dati, imponendo un equilibrio tra utilizzo produttivo delle informazioni e tutela dei dati personali dei lavoratori, anche rispetto a concorrenza e proprietà intellettuale. In ambito industriale resta delicata la distinzione tra “dati macchina” e dati personali”: le telemetrie e i dati tecnici vanno trattati come personali quando consentono, anche indirettamente, di identificare o valutare un lavoratore (caso tipico nella gig economy). Ciò richiede procedure di anonimizzazione o minimizzazione tracciabili e verificabili.

Sul piano sistemico si apre infine il tema — ancora irrisolto ma sempre più discusso anche a livello internazionale — della proprietà dei dati generati dal lavoro umano, destinato a diventare uno dei nodi politici e regolatori dei prossimi anni.

Un quadro nazionale di raccordo, la Legge 132/2025

La Legge 132/2025 rappresenta il principale strumento nazionale di attuazione dell’AI Act e introduce, presso il Ministero del Lavoro, l’Osservatorio nazionale sull’IA, con il compito di promuovere principi di etica, trasparenza e non discriminazione anche nei contesti lavorativi. La legge prevede inoltre linee guida nazionali per l’uso sicuro dell’IA nei processi produttivi, formativi e gestionali, con particolare attenzione a PMI e settori ad alta automazione.

Sul piano operativo, la normativa impone ai datori di lavoro di integrare la valutazione dell’impatto algoritmico nel risk management aziendale, raccordando DPIA (GDPR), obblighi di conformità dell’AI Act e analisi dei rischi etici, reputazionali e organizzativi. Sono inoltre richiesti audit periodici sulla qualità dei dati e attività di formazione del personale, per garantire un utilizzo consapevole e sicuro dei sistemi di IA.

Responsabilità organizzativa e modelli di compliance (D.Lgs. 231/2001)

Il D.Lgs. 231/2001, nato per prevenire i reati d’impresa, assume oggi un nuovo ruolo alla luce dell’utilizzo dell’intelligenza artificiale, che può generare rischi legati a discriminazioni, violazioni della privacy, lesioni dei diritti dei lavoratori e omissioni di vigilanza. La Legge 132/2025 ha introdotto le prime modifiche in ambito penale e delegato il Governo ad ampliare le fattispecie di reato connesse all’uso dell’IA, che andranno a incidere sul catalogo dei reati presupposto della responsabilità dell’ente.

Ne consegue la necessità di aggiornare i modelli organizzativi 231, includendo l’IA nella mappatura dei rischi e nelle procedure di controllo interno. L’ampliamento “algoritmico” dei reati, insieme al nuovo quadro europeo (in particolare il Data Act), impone alle imprese di estendere i presidi di compliance ai rischi derivanti dalla governance dei dati e dalle decisioni automatizzate. L’Organismo di Vigilanza dovrà quindi coordinarsi con Audit, DPO e RSPP, prevedendo formazione mirata, procedure dedicate e un possibile AI Risk Register con audit periodici, per dimostrare l’adempimento degli obblighi di vigilanza ex art. 6 del D.Lgs. 231/2001.

Sicurezza, salute e impatto dei sistemi AI (D.Lgs. 81/2008)

Il Testo Unico sulla Sicurezza (D.Lgs. 81/2008), e in particolare il poco valorizzato Allegato XXXIV, deve oggi essere reinterpretato alla luce dei nuovi rischi introdotti dall’automazione intelligente. Tale allegato, che disciplina informazione e formazione dei lavoratori, diventa la base per una vera e propria “sicurezza algoritmica”.

In questo nuovo contesto:

-

la formazione “sufficiente e adeguata” diventa AI literacy, ossia capacità di usare consapevolmente i sistemi di IA e riconoscerne errori, bias e falsi positivi;

-

la valutazione dei rischi (DVR) deve includere rischi cognitivi, decisionali e psicosociali, connessi a opacità, sorveglianza continua, automazione o dipendenza da sistemi predittivi e cobot;

-

la cooperazione tra datore, dirigenti e RSPP si amplia a DPO e figure tecniche dell’IA (es. Chief AI Officer), per integrare profili giuridici, etici e di sicurezza.

La mancata formazione su questi aspetti può comportare violazioni dell’art. 37 TU 81/08 e possibili responsabilità datoriali per “infortunio digitale”. Le linee guida INAIL 2025 e la proposta europea di “AI safety by training” confermano questa estensione: la sicurezza non è più solo fisica, ma anche cognitiva, informativa e algoritmica. INAIL e Garante raccomandano quindi di valutare:

(a) gli effetti della sorveglianza algoritmica sul benessere mentale,

(b) i rischi di sostituzione decisionale automatica,

(c) la formazione alla supervisione umana dei sistemi.